- Roblox همیشه برای محافظت از جوانترین کاربران ما طراحی شده است. ما اکنون در حال تطبیق با مخاطبان رو به رشد کاربران مسن هستیم.

- با متن، صدا، تصاویر، مدل های سه بعدی و کد، Roblox در موقعیتی منحصر به فرد برای موفقیت با راه حل های هوش مصنوعی چندوجهی قرار دارد.

- از طریق منبع باز، همکاری با شرکا یا حمایت از قوانین، ایمنی را در هر کجا که بتوانیم در صنعت بهبود میبخشیم.

ایمنی و مدنیت برای Roblox از زمان شروع آن تقریباً دو دهه پیش پایه و اساس بوده است. در روز اول، ما متعهد شدیم که ویژگیهای ایمنی، ابزارها و قابلیتهای تعدیل را در طراحی محصولات خود ایجاد کنیم. قبل از اینکه هر ویژگی جدیدی را راه اندازی کنیم، قبلاً در مورد چگونگی ایمن نگه داشتن جامعه از آسیب های احتمالی فکر کرده ایم. این فرآیند طراحی ویژگیها برای ایمنی و مدنیت از ابتدا، از جمله آزمایشهای اولیه برای مشاهده اینکه چگونه ممکن است از یک ویژگی جدید سوء استفاده شود، به ما کمک میکند تا نوآوری کنیم. ما به طور مستمر آخرین تحقیقات و فناوری های موجود را ارزیابی می کنیم تا سیاست ها، ابزارها و سیستم های خود را تا حد امکان دقیق و کارآمد نگه داریم.

هنگامی که صحبت از ایمنی به میان می آید، Roblox موقعیت منحصر به فردی دارد. اکثر پلتفرمها به عنوان مکانی برای بزرگسالان شروع به کار کردند و اکنون به طور عطف به ماسبق برای ایجاد حفاظ برای نوجوانان و کودکان کار میکنند. اما پلتفرم ما از ابتدا به عنوان یک فضای امن و محافظتی برای کودکان برای ایجاد و یادگیری توسعه داده شد، و ما اکنون در حال تطبیق با مخاطبانی هستیم که به سرعت در حال رشد هستند و در حال افزایش سن هستند. علاوه بر این، حجم محتوایی که ما تعدیل میکنیم، به لطف ویژگیها و ابزارهای هیجانانگیز هوش مصنوعی مولد جدید که به افراد بیشتری امکان میدهد به راحتی در Roblox ایجاد و ارتباط برقرار کنند، بهطور تصاعدی افزایش یافته است. اینها چالشهای غیرمنتظره نیستند - ماموریت ما این است که یک میلیارد نفر را با خوشبینی و متمدن به هم وصل کنیم. ما همیشه به آینده می نگریم تا بفهمیم با رشد و انطباق به چه سیاست ها و ابزارهای ایمنی جدیدی نیاز خواهیم داشت.

بسیاری از ویژگیها و ابزارهای ایمنی ما مبتنی بر راهحلهای خلاقانه هوش مصنوعی هستند که در کنار یک تیم متخصص متشکل از هزاران نفر که به ایمنی اختصاص دارند، اجرا میشوند. این ترکیب استراتژیک از انسانهای باتجربه و اتوماسیون هوشمند ضروری است، زیرا تلاش میکنیم تا حجم محتوایی را که به صورت 24 ساعته تعدیل میکنیم، افزایش دهیم. ما همچنین به پرورش مشارکت با سازمانهای متمرکز بر ایمنی آنلاین اعتقاد داریم، و در صورت لزوم، از قوانینی حمایت میکنیم که قویاً معتقدیم صنعت را در کل بهبود میبخشد.

پیشروی با هوش مصنوعی به مقیاس ایمن

مقیاس بزرگ پلتفرم ما سیستمهای هوش مصنوعی را میطلبد که معیارهای پیشرو در صنعت را برای دقت و کارایی برآورده میکنند یا به ما اجازه میدهند با رشد جامعه، تکامل سیاستها و الزامات و بروز چالشهای جدید، به سرعت پاسخ دهیم. امروزه بیش از 71 میلیون کاربر فعال روزانه در 190 کشور جهان با Roblox ارتباط برقرار کرده و محتوا را به اشتراک می گذارند. هر روز، مردم میلیاردها پیام چت برای دوستان خود در Roblox ارسال می کنند. ما فروشگاه سازندگان میلیونها مورد برای فروش دارد - و سازندگان آواتارها و آیتمهای جدیدی را به آن اضافه میکنند بازار هر روز. و با ادامه رشد و ایجاد راههای جدیدی برای افراد برای ایجاد و برقراری ارتباط در Roblox، این تنها بزرگتر میشود.

از آنجایی که صنعت گستردهتر جهشهای زیادی در یادگیری ماشین (ML)، مدلهای زبان بزرگ (LLM) و هوش مصنوعی چندوجهی انجام میدهد، ما سرمایهگذاری زیادی روی راههایی برای استفاده از این راهحلهای جدید برای ایمنتر کردن Roblox انجام میدهیم. راه حل های هوش مصنوعی در حال حاضر به ما کمک می کنند تا چت متنی را تعدیل کنیم، ارتباط صوتی همهجانبه، تصاویر و مدل ها و مش های سه بعدی. ما اکنون از بسیاری از همین فناوریها برای ایجاد ایجاد در Roblox استفاده میکنیم سریع تر و راحت تر برای جامعه ما

نوآوری با سیستمهای هوش مصنوعی چندوجهی

پلتفرم ما بنا به ماهیت خود متن، صدا، تصاویر، مدل های سه بعدی و کد را ترکیب می کند. هوش مصنوعی چندوجهی، که در آن سیستمها بر روی چندین نوع داده با هم آموزش میبینند تا نتایج دقیقتر و پیچیدهتری نسبت به یک سیستم تکوجهی تولید کنند، فرصتی منحصربهفرد برای Roblox ایجاد میکند. سیستمهای چندوجهی قادر به تشخیص ترکیبی از انواع محتوا (مانند تصاویر و متن) هستند که ممکن است به گونهای مشکل ساز باشند که عناصر منفرد نیستند. برای تصور اینکه چگونه این کار میتواند کار کند، فرض کنید یک بچه از آواتاری استفاده میکند که شبیه خوک است - کاملاً خوب، درست است؟ حالا تصور کنید که شخص دیگری یک پیام چت می فرستد که می گوید "این دقیقاً شبیه شماست! این پیام ممکن است خطمشیهای ما در مورد قلدری را نقض کند.

مدلی که فقط بر روی مدل های سه بعدی آموزش دیده باشد، آواتار را تایید می کند. و مدلی که فقط بر روی متن آموزش دیده باشد، متن را تایید می کند و متن آواتار را نادیده می گیرد. فقط چیزی که در مدلهای متنی و سهبعدی آموزش دیده باشد، میتواند به سرعت مشکل را در این مثال شناسایی و پرچمگذاری کند. ما در روزهای اولیه برای این مدلهای چندوجهی هستیم، اما دنیایی را در آیندهای نه چندان دور میبینیم که در آن سیستم ما با بررسی یک تجربه کامل به گزارش سوءاستفاده پاسخ میدهد. میتواند کد، تصاویر، آواتارها و ارتباطات درون آن را به عنوان ورودی پردازش کند و تعیین کند که آیا تحقیقات بیشتر یا پیامد آن ضروری است یا خیر.

ما قبلاً با استفاده از تکنیکهای چندوجهی، مانند مدلی که نقض خطمشی در ارتباطات صوتی را تقریباً در زمان واقعی تشخیص میدهد، پیشرفتهای چشمگیری داشتهایم. هنگامی که فرصتی برای افزایش ایمنی و مدنیت نه تنها در Roblox بلکه در سراسر صنعت می بینیم، قصد داریم چنین پیشرفت هایی را به اشتراک بگذاریم. در واقع، ما اولین مدل منبع باز خود، طبقهبندی کننده ایمنی صوتی را با صنعت به اشتراک میگذاریم.

تعدیل محتوا در مقیاس

در Roblox، ما اکثر انواع محتوا را بررسی میکنیم تا نقض خطمشیهای مهم را دریافت کنیم قبل از آنها روی سکو ظاهر می شوند. انجام این کار بدون ایجاد تاخیر قابل توجه برای افرادی که محتوای خود را منتشر می کنند، به سرعت و همچنین دقت نیاز دارد. راه حل های پیشگامانه هوش مصنوعی به ما کمک می کند تا در زمان واقعی تصمیمات بهتری بگیریم تا محتوای مشکل ساز را از Roblox دور نگه داریم - و اگر چیزی به پلتفرم راه پیدا کرد، ما سیستم هایی برای شناسایی و حذف آن محتوا داریم، از جمله قوی خود. سیستم های گزارش دهی کاربر.

ما دیدهایم که دقت ابزارهای تعدیل خودکار ما در مورد کارهای ساده و قابل تکرار، از تعدیلکنندگان انسانی فراتر رفته است. با خودکارسازی این موارد سادهتر، ناظران انسانی خود را آزاد میکنیم تا بیشتر وقت خود را صرف کارهایی کنند که به بهترین شکل انجام میدهند - کارهای پیچیدهتری که نیاز به تفکر انتقادی و بررسی عمیقتر دارند. با این حال، وقتی صحبت از ایمنی به میان میآید، میدانیم که اتوماسیون نمیتواند به طور کامل جایگزین بررسی انسانی شود. ناظران انسانی ما برای کمک به ما در نظارت و آزمایش مداوم مدلهای ML خود از نظر کیفیت و سازگاری، و ایجاد مجموعههای داده برچسبدار با کیفیت بالا برای به روز نگه داشتن سیستمهایمان بسیار ارزشمند هستند. آنها به شناسایی عامیانه و اختصارات جدید در تمام 16 زبانی که پشتیبانی می کنیم کمک می کنند و مواردی را که به طور مکرر ظاهر می شوند علامت گذاری می کنند تا سیستم بتواند آنها را تشخیص دهد.

ما می دانیم که حتی سیستم های ML با کیفیت بالا نیز می توانند اشتباه کنند، بنابراین ما در فرآیند تجدید نظر خود ناظر انسانی داریم. ناظران ما به ما کمک میکنند تا آن را برای فردی که درخواست تجدیدنظر را ارائه کرده است درست کنیم، و میتوانند نیاز به آموزش بیشتر در مورد انواع مواردی که در آنها اشتباه شده است را اعلام کنند. با این کار، سیستم ما در طول زمان به طور فزاینده ای دقیق می شود و اساساً از اشتباهات خود درس می گیرد.مهمتر از همه، انسانها همیشه درگیر هر گونه تحقیقات حیاتی مربوط به موارد پرخطر، مانند افراطگرایی یا به خطر انداختن کودکان هستند. برای این موارد، ما یک تیم داخلی اختصاصی داریم که فعالانه عوامل مخرب را شناسایی و حذف کرده و پروندههای دشوار را در بحرانیترین مناطقمان بررسی میکنند. این تیم همچنین با تیم محصول ما همکاری میکند و بینشهایی را از کاری که انجام میدهند برای بهبود مستمر ایمنی پلتفرم و محصولات ما به اشتراک میگذارد.

تعدیل ارتباطات

فیلتر متن ما بر روی زبان مخصوص Roblox، از جمله زبان عامیانه و اختصارات آموزش داده شده است. 2.5 میلیارد پیام چت که هر روز در Roblox ارسال می شود از این فیلتر عبور می کند که در تشخیص زبان نقض کننده خط مشی ماهر است. این فیلتر نقضها را در همه زبانهایی که پشتیبانی میکنیم شناسایی میکند، که اکنون که ما بهطور همزمان منتشر کردهایم بسیار مهم است ترجمه چت هوش مصنوعی.

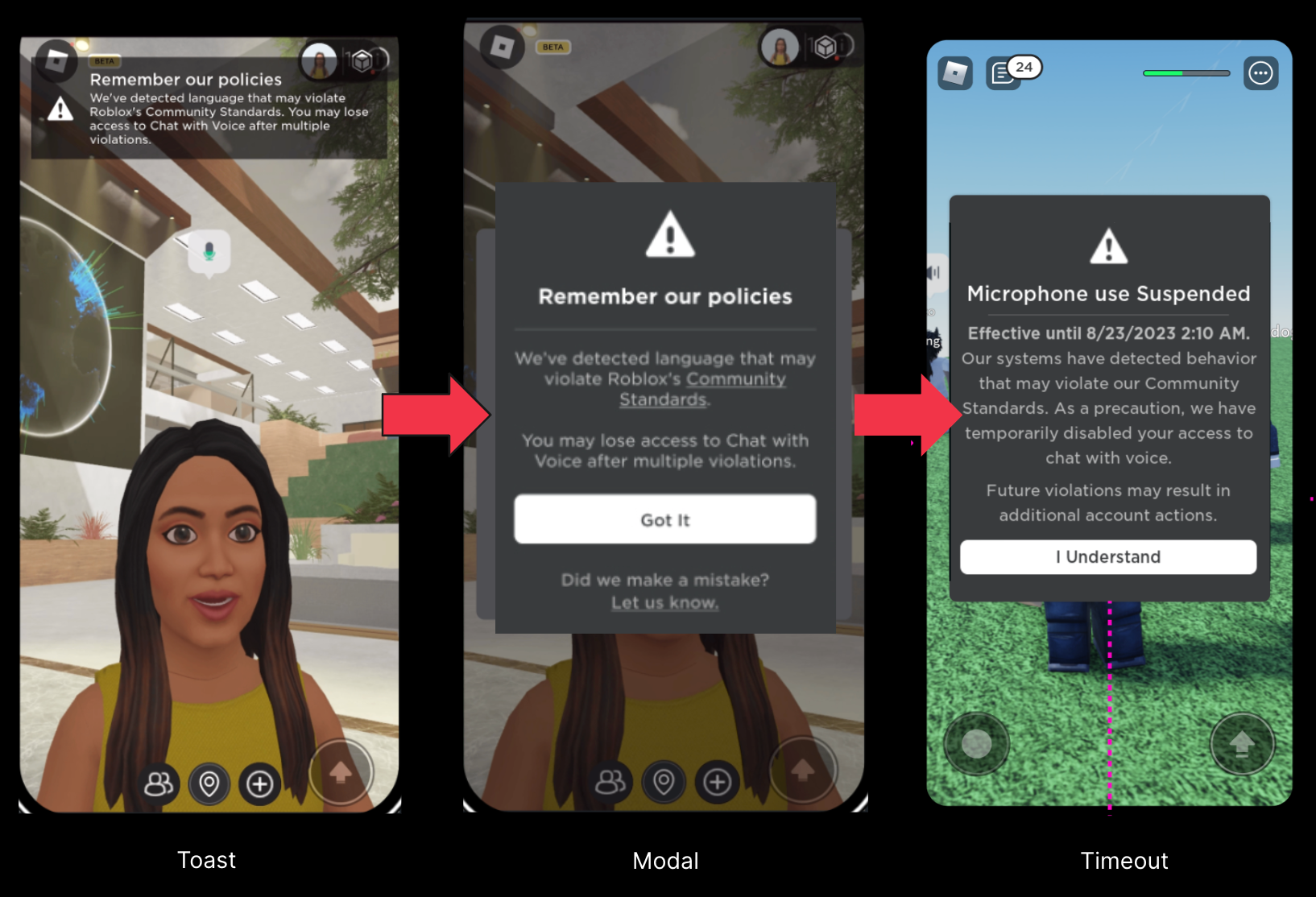

ما قبلا نحوه کار را به اشتراک گذاشته ایم ارتباط صوتی متوسط در زمان واقعی از طریق یک سیستم تشخیص صدای سفارشی داخلی. نوآوری در اینجا این است که میتوان مستقیماً از صدای زنده به سمت برچسبگذاری سیستم هوش مصنوعی بر روی صدا بهعنوان خطمشی ناقض یا نه در عرض چند ثانیه رفت. وقتی شروع به آزمایش سیستم تعدیل صدای خود کردیم، متوجه شدیم که در بسیاری از موارد، افراد ناخواسته خطمشیهای ما را نقض میکنند، زیرا با قوانین ما آشنا نیستند. ما یک سیستم ایمنی بیدرنگ ایجاد کردیم تا به افراد کمک کند وقتی صحبتهایشان یکی از خطمشیهای ما را نقض میکند، مطلع شویم.

این اعلانها یک هشدار اولیه و خفیف هستند، شبیه به اینکه مؤدبانه از شما خواسته میشود در یک پارک عمومی با کودکان خردسال در اطراف تماشای زبان خود را تماشا کنید. در آزمایش، این مداخلات در یادآوری افراد برای احترام و هدایت آنها به سمت سیاستهای ما برای یادگیری بیشتر موفق بوده است. در مقایسه با دادههای تعامل، نتایج آزمایش ما دلگرمکننده است و نشان میدهد که این ابزارها ممکن است به طور موثر بازیگران بد را از پلتفرم دور نگه دارند در حالی که کاربران واقعاً درگیر را تشویق میکنند تا رفتار خود را در Roblox بهبود بخشند. از زمان ارائه ایمنی بیدرنگ برای همه کاربران انگلیسیزبان در ژانویه، شاهد کاهش ۵۳ درصدی گزارشهای سوءاستفاده به ازای هر کاربر فعال روزانه در ارتباط با ارتباطات صوتی بودهایم.

تعدیل ایجاد

برای دارایی های بصری، از جمله آواتارها و لوازم جانبی آواتار، از بینایی کامپیوتر (CV) استفاده می کنیم. یک تکنیک شامل گرفتن عکس از آیتم از زوایای مختلف است. سپس سیستم آن عکسها را بررسی میکند تا مرحله بعدی را مشخص کند. اگر چیزی اشتباه به نظر نمی رسد، مورد تایید می شود. اگر چیزی به وضوح خطمشی را نقض میکند، آن مورد مسدود میشود و ما به سازنده میگوییم که چه چیزی اشتباه است. اگر سیستم مطمئن نباشد، مورد به یک ناظر انسانی فرستاده می شود تا نگاه دقیق تری داشته باشد و تصمیم نهایی را بگیرد.

ما نسخه ای از همین فرآیند را برای آواتارها، لوازم جانبی، کدها و مدل های سه بعدی کامل انجام می دهیم. برای مدلهای کامل، یک قدم فراتر میرویم و تمام کدها و سایر عناصر تشکیلدهنده مدل را ارزیابی میکنیم. اگر ما در حال ارزیابی یک خودرو هستیم، آن را به اجزای آن – فرمان، صندلیها، لاستیکها و کد زیر همه آنها – تقسیم میکنیم تا مشخص کنیم که آیا ممکن است مشکلساز باشد یا خیر. اگر آواتاری وجود دارد که شبیه توله سگ است، باید بررسی کنیم که آیا گوش، بینی و زبان مشکل دارند یا خیر.

باید بتوانیم در جهت دیگر نیز ارزیابی کنیم. اگر اجزای جداگانه همه کاملاً خوب باشند اما تأثیر کلی آنها خطمشیهای ما را نقض کند چه؟ مثلاً سبیل، ژاکت خاکی و بازوبند قرمز به خودی خود مشکلی ندارند. اما تصور کنید که اینها روی آواتار یک نفر با هم مونتاژ شده اند، با نمادی صلیب مانند روی بازوبند و یک دست بلند شده به نشانه سلام نازی ها، و مشکل مشخص می شود.

این جایی است که مدلهای داخلی ما با مدلهای CV موجود در بازار تفاوت دارند. این افراد معمولاً بر روی آیتم های دنیای واقعی آموزش می بینند. آنها می توانند یک ماشین یا یک سگ را تشخیص دهند اما نه اجزای سازنده آن چیزها را. مدلهای ما برای ارزیابی موارد تا کوچکترین اجزای سازنده آموزش و بهینهسازی شدهاند.

همکاری با شرکا

ما از همه ابزارهای موجود برای ایمن نگه داشتن همه افراد در Roblox استفاده می کنیم - اما به همان اندازه احساس می کنیم آنچه را فراتر از Roblox می آموزیم به اشتراک بگذاریم. در واقع، ما اولین مدل منبع باز خود را به اشتراک می گذاریم، یک طبقه بندی کننده ایمنی صوتی، تا به دیگران کمک کنیم تا سیستم های ایمنی صوتی خود را بهبود بخشند. ما همچنین با گروه های شخص ثالث برای به اشتراک گذاشتن دانش و بهترین شیوه ها با پیشرفت صنعت همکاری می کنیم. ما با طیف وسیعی از سازمانها، از جمله گروههای حمایت از والدین، سازمانهای سلامت روان، سازمانهای دولتی و سازمانهای مجری قانون، روابط نزدیک برقرار میکنیم و حفظ میکنیم. آنها بینش های ارزشمندی را در مورد نگرانی های والدین، سیاست گذاران و سایر گروه ها در مورد ایمنی آنلاین به ما می دهند. در عوض، ما میتوانیم آموختهها و فناوریهایی را که برای ایمن نگهداشتن پلتفرم استفاده میکنیم به اشتراک بگذاریم.

ما سابقه ای در زمینه قرار دادن ایمنی جوان ترین و آسیب پذیرترین افراد در پلت فرم خود داریم. ما برنامه هایی مانند برنامه های خود را ایجاد کرده ایم برنامه پرچمدار معتمد، به ما کمک می کند تا زمانی که برای محافظت از افراد در پلت فرم خود تلاش می کنیم، دسترسی خود را افزایش دهیم. ما با سیاستگذاران در ابتکارات کلیدی ایمنی کودکان، قوانین و سایر تلاشها همکاری میکنیم. به عنوان مثال، ما اولین و یکی از تنها شرکت هایی بودیم که از قانون کد طراحی مناسب سن کالیفرنیا حمایت کردیم، زیرا معتقدیم این قانون به نفع جوانان است. وقتی معتقدیم چیزی به جوانان کمک می کند، می خواهیم آن را به همه تبلیغ کنیم. اخیراً نامه ای برای حمایت امضا کردیم بیل کالیفرنیا SB 933، که قوانین ایالتی را به روز می کند تا صراحتاً مواد سوء استفاده جنسی از کودکان ایجاد شده توسط هوش مصنوعی را ممنوع کند.

کار به سوی آینده ای امن تر

این کار هیچ وقت تمام نمی شود. ما در حال حاضر روی نسل بعدی ابزارها و ویژگیهای ایمنی کار میکنیم، حتی با اینکه ایجاد را برای هر کسی در Roblox آسانتر میکنیم. همانطور که رشد میکنیم و راههای جدیدی برای ایجاد و اشتراکگذاری ارائه میکنیم، به توسعه راهحلهای جدید و پیشگامانه برای ایمن نگه داشتن همه افراد در Roblox و فراتر از آن ادامه خواهیم داد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://blog.roblox.com/2024/04/scaling-safety-civility-roblox/

- 1

- 16

- 3d

- a

- توانایی

- قادر

- درباره ما

- سو استفاده کردن

- لوازم

- دقت

- دقیق

- در میان

- عمل

- فعال

- بازیگران

- وفق دادن

- سازگار بودن

- اضافه کردن

- افزودن

- ماهر

- بزرگسالان

- پیشرفت

- دفاع

- در برابر

- سازمان

- سالخورده

- پیش

- AI

- سیستم های هوش مصنوعی

- وابسته

- معرفی

- اجازه دادن

- در کنار

- قبلا

- همچنین

- همیشه

- an

- و

- هر

- هر کس

- هر چیزی

- استیناف

- تجدید نظر

- ظاهر شدن

- تصویب

- تایید کرد

- هستند

- مناطق

- بوجود می آیند

- ARM

- دور و بر

- as

- مونتاژ

- ارزیابی کنید

- ارزیابی

- دارایی

- At

- حضار

- سمعی

- خودکار

- اتوماسیون

- اتوماسیون

- در دسترس

- نماد

- آواتار

- بد

- مستقر

- BE

- زیرا

- شود

- بوده

- قبل از

- آغاز شد

- شروع

- شروع شد

- رفتار

- بودن

- باور

- معیار

- بهترین

- بهترین شیوه

- بهتر

- خارج از

- لایحه

- بیلیون

- میلیاردها

- مخلوط

- مسدود شده

- بلاگ

- شکستن

- گسترده تر

- ساختن

- بنا

- قلدری

- اما

- by

- کالیفرنیا

- CAN

- قابلیت های

- توانا

- ماشین

- موارد

- کشتی

- باعث می شود

- چالش ها

- گپ

- کودک

- ایمنی کودک

- فرزندان

- مدنی

- طبقه بندی

- واضح

- به وضوح

- نزدیک

- نزدیک

- رمز

- همکاری

- همکاری

- ترکیب

- بیا

- می آید

- مرتکب شده

- ارتباط

- ارتباط

- ارتباطات

- انجمن

- شرکت

- مقایسه

- به طور کامل

- پیچیده

- جزء

- اجزاء

- کامپیوتر

- بینایی کامپیوتر

- نگرانی ها

- اتصال

- نتیجه

- محتوا

- زمینه

- به طور مستمر

- ادامه دادن

- میتوانست

- کشور

- ایجاد

- ایجاد

- ایجاد

- خالق

- سازندگان

- بحرانی

- جاری

- سفارشی

- روزانه

- کاربران فعال روزانه

- داده ها

- روز

- روز

- دهه

- تصمیم

- تصمیم گیری

- اختصاصی

- عمیق تر

- تاخیر

- خواسته

- طرح

- طراحی

- طراحی

- تشخیص

- کشف

- مشخص کردن

- توسعه

- توسعه

- متفاوت است

- مشکل

- هدایت

- جهت

- مستقیما

- دور

- do

- میکند

- سگ

- عمل

- پایین

- در اوایل

- آسان تر

- به آسانی

- اثر

- به طور موثر

- بهره وری

- موثر

- تلاش

- عناصر

- دیگر

- قدرت دادن

- قادر ساختن

- دلگرم کننده

- اجرای

- مشغول

- نامزدی

- تمام

- به همان اندازه

- به خصوص

- اساسا

- تاسیس

- ارزیابی

- حتی

- هر

- هر کس

- تکامل

- تکامل می یابد

- مثال

- مهیج

- تجربه

- با تجربه

- کارشناس

- نمایی

- واقعیت

- آشنا

- ویژگی

- امکانات

- احساس

- واصل

- فیلتر

- نهایی

- پایان

- نام خانوادگی

- متمرکز شده است

- برای

- یافت

- بنیادین

- رایگان

- غالبا

- دوستان

- از جانب

- کامل

- بیشتر

- آینده

- عموما

- نسل.

- مولد

- هوش مصنوعی مولد

- گرفتن

- دادن

- go

- دولت

- سازمان های دولتی

- بزرگ

- پیشگامانه

- شدن

- در حال رشد

- رشد کرد

- رشد می کند

- است

- آیا

- داشتن

- سلامتی

- به شدت

- کمک

- کمک

- کمک می کند

- اینجا کلیک نمایید

- کیفیت بالا

- ریسک بالا

- چگونه

- چگونه

- اما

- HTTPS

- انسان

- انسان

- شناسایی

- if

- چشم پوشی از

- تصاویر

- تصور کنید

- امری ضروری

- مهم

- بهبود

- in

- آغازگر

- از جمله

- افزایش

- به طور فزاینده

- نشان دادن

- فرد

- صنعت

- پیشرو در صنعت

- ابتکارات

- نوآوری

- ابداع

- ابتکاری

- ورودی

- بینش

- هوشمند

- قصد

- علاقه

- داخلی

- مداخلات

- به

- فوق العاده گرانبها

- سرمایه گذاری

- بررسی

- تحقیق

- گرفتار

- شامل

- شامل

- Is

- موضوع

- IT

- اقلام

- ITS

- ژانویه

- تنها

- نگه داشتن

- کلید

- دانستن

- دانش

- برچسب

- زبان

- زبان ها

- بزرگ

- بزرگتر

- آخرین

- راه اندازی

- قانون

- اجرای قانون

- قوانین

- یاد گرفتن

- یادگیری

- قانون

- قدرت نفوذ

- پسندیدن

- زنده

- نگاه کنيد

- به دنبال

- به نظر می رسد

- دستگاه

- فراگیری ماشین

- ساخته

- حفظ

- ساخت

- باعث می شود

- مخرب

- بسیاری

- ماده

- ماده

- ممکن است

- ملاقات

- روانی

- سلامت روان

- پیام

- پیام

- قدرت

- میلیون

- میلیون ها نفر

- ماموریت

- اشتباهات

- ML

- مدل

- مدل

- متوسط

- اعتدال

- مدیران

- بیش

- اکثر

- چندگانه

- طبیعت

- نزدیک

- تقریبا

- نیاز

- هرگز

- جدید

- ویژگی های جدید

- راه حل های جدید

- بعدی

- بینی

- نه

- هیچ چی

- اطلاعیه ها

- اکنون

- پرورش دادن

- of

- خاموش

- بزرگتر

- on

- یک

- آنلاین

- فقط

- باز کن

- منبع باز

- فرصت

- خوش بینی

- بهینه

- or

- سازمان های

- دیگر

- دیگران

- ما

- خارج

- ابتدا

- روی

- به طور کلی

- نظارت

- خود

- پدر و مادر

- پارک

- شریک

- شرکای

- مشارکت

- بخش

- مردم

- برای

- در صد

- کاملا

- محل

- سکو

- سیستم عامل

- افلاطون

- هوش داده پلاتو

- پلاتوداتا

- بازی پلاتو

- سیاست

- سیاست

- سیاستگذاران

- موقعیت

- موقعیت یابی شده

- ممکن

- پتانسیل

- شیوه های

- هدیه

- قبلا

- مشکل

- روند

- محصول

- محصول

- محصولات

- برنامه ها

- محافظت از

- محافظ

- ثابت

- ارائه

- عمومی

- انتشار

- قرار دادن

- کیفیت

- به سرعت

- مطرح شده

- محدوده

- سریعا

- رسیدن به

- واقعی

- دنیای واقعی

- زمان واقعی

- تازه

- شناختن

- رکورد

- قرمز

- کاهش

- مرتبط

- روابط

- منتشر شد

- مربوط

- یادآوری

- برداشتن

- جایگزین کردن

- گزارش

- گزارش

- گزارش ها

- نیاز

- مورد نیاز

- نیاز

- تحقیق

- پاسخ

- نتایج

- برگشت

- این فایل نقد می نویسید:

- بررسی

- راست

- Roblox

- تنومند

- نورد

- نورد کردن

- قوانین

- دویدن

- امن

- با خیال راحت

- امن تر

- ایمنی

- سلامت

- همان

- گفتن

- می گوید:

- مقیاس

- مقیاس گذاری

- ثانیه

- دیدن

- به نظر می رسد

- مشاهده گردید

- ارسال

- می فرستد

- فرستاده

- مجموعه

- اشتراک گذاری

- به اشتراک گذاشته شده

- اشتراک

- باید

- امضاء شده

- قابل توجه

- ساده

- ساده تر

- پس از

- So

- مزایا

- کسی

- چیزی

- مصنوعی

- منبع

- فضا

- سرعت

- خرج کردن

- دولت

- فرمان

- فرمان

- گام

- استراتژیک

- به شدت

- موفق شدن

- موفق

- چنین

- پشتیبانی

- مطمئن

- پیش افتادن از

- نماد

- سیستم

- سیستم های

- گرفتن

- مصرف

- وظایف

- تیم

- تکنیک

- تکنیک

- فن آوری

- پیشرفته

- نوجوانان

- گفتن

- آزمون

- تست

- متن

- نسبت به

- با تشکر

- که

- La

- آینده

- شان

- آنها

- سپس

- اینها

- آنها

- اشیاء

- فکر می کنم

- تفکر

- این

- کسانی که

- هزاران نفر

- از طریق

- زمان

- لاستیک

- به

- امروز

- با هم

- هم

- ابزار

- بالا

- نسبت به

- مسیر

- رکورد

- آموزش دیده

- آموزش

- صادقانه

- دو

- انواع

- در زیر

- درک کن

- غیر منتظره

- منحصر به فرد

- منحصر به فرد

- up

- به روز رسانی

- us

- استفاده کنید

- کاربر

- کاربران

- با استفاده از

- با ارزش

- نسخه

- بسیار

- از طريق

- تخلفات

- دید

- بصری

- تصاویر

- صدا

- حجم

- آسیب پذیر

- می خواهم

- هشدار

- بود

- تماشا کردن

- راه

- we

- خوب

- بود

- چی

- چرخ

- چه زمانی

- جایی که

- هر کجا که

- چه

- در حین

- WHO

- تمام

- وسیع

- طیف گسترده ای

- اراده

- با

- در داخل

- بدون

- مهاجرت کاری

- کارگر

- جهان

- خواهد بود

- اشتباه

- جوان

- جوانترین

- خود را

- زفیرنت